왜 지금 로컬 AI가 주목받는가?

클라우드 AI 서비스의 월 사용료가 부담스럽다고 느끼신 적 있으신가요? 매번 API 호출할 때마다 쌓이는 비용을 보며 고민이 깊어지는 개발자라면, 이제 새로운 해결책을 만나보실 시간입니다.

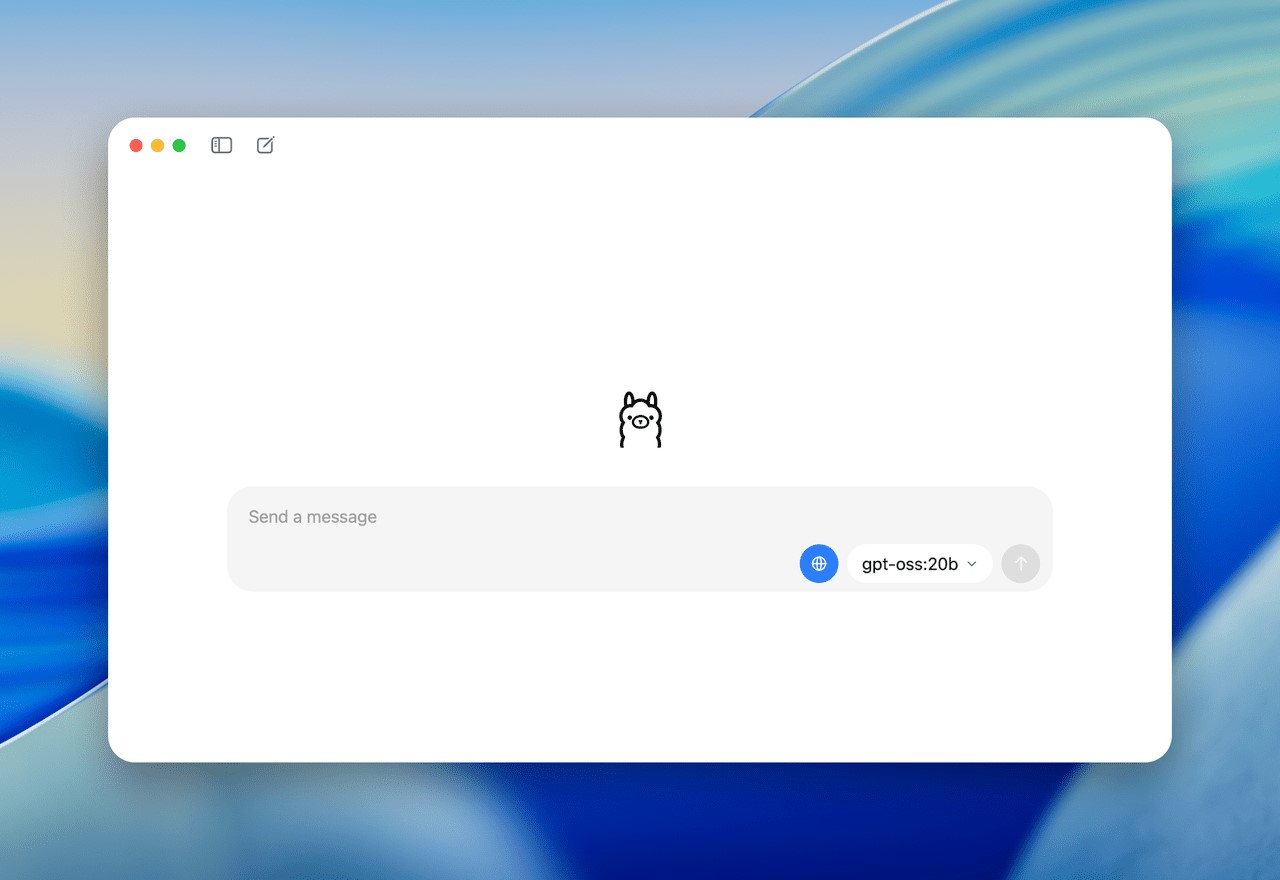

OpenAI의 GPT-OSS 모델이 오픈 웨이트로 공개되면서, 여러분의 컴퓨터에서 직접 강력한 언어 모델을 실행할 수 있게 되었습니다. 단순히 비용 절감을 넘어서, 완전한 프라이버시와 무제한 사용이라는 혁신적 가치를 제공하죠.

Ollama와 GPT-OSS의 만남: 로컬 AI의 새로운 패러다임

로컬 실행이 가져다주는 3가지 핵심 이점

1. 절대적 데이터 프라이버시

여러분의 모든 입력과 출력이 개인 기기에서만 처리됩니다. 민감한 코드나 기업 데이터를 다룰 때 외부 서버로 전송할 필요가 없어, 완벽한 보안성을 보장받을 수 있습니다.

2. 무제한 비용 절감

반복적인 클라우드 API 비용에서 완전히 해방됩니다. 초기 하드웨어 투자만으로 무한히 사용 가능한 AI 환경을 구축할 수 있습니다.

3. 완전한 커스터마이징 자유도

모델의 동작 방식, 응답 스타일, 특화 기능까지 여러분의 필요에 맞게 세밀하게 조정할 수 있습니다.

GPT-OSS 모델 선택 가이드

gpt-oss-20b: 데스크톱 친화적 선택

- 필요 메모리: 16GB RAM

- 토큰당 활성 매개변수: 3.6B

- 적합한 용도: 개인 프로젝트, 학습, 실험

gpt-oss-120b: 엔터프라이즈급 성능

- 필요 메모리: 80GB GPU

- 토큰당 활성 매개변수: 5.1B

- 적합한 용도: 대규모 상용 프로젝트, 연구

단계별 구축 가이드

1단계: 시스템 준비 및 Ollama 설치

먼저 여러분의 하드웨어가 GPT-OSS 실행에 충분한지 확인해보겠습니다. NVIDIA 1060 4GB 정도의 GPU만 있어도 gpt-oss-20b는 충분히 실행 가능합니다.

macOS/Linux 사용자

curl -fsSL https://ollama.com/install.sh | sh설치 확인

ollama --version버전 정보가 출력된다면 성공적으로 설치된 것입니다.

2단계: GPT-OSS 모델 다운로드

이제 실제 AI 모델을 다운로드할 차례입니다. 네트워크 상황에 따라 20-50GB의 파일 다운로드가 진행되므로, 안정적인 인터넷 연결 상태에서 진행하시기 바랍니다.

# 일반 사용자 권장

ollama pull gpt-oss-20b

# 고성능 환경 보유자

ollama pull gpt-oss-120b3단계: 첫 실행과 기본 상호작용

드디어 여러분만의 AI 어시스턴트와 대화할 시간입니다.

ollama run gpt-oss-20b실행되면 대화형 인터페이스가 나타나며, 이제 어떤 질문이든 자유롭게 할 수 있습니다. “Python으로 웹 스크래핑 코드를 작성해줘”처럼 구체적인 요청도 가능합니다.

4단계: Modelfile로 AI 성격 커스터마이징

여기서부터 진짜 재미있는 부분이 시작됩니다. Modelfile을 통해 AI의 ‘성격’과 전문성을 여러분의 용도에 맞게 조정할 수 있습니다.

전문 코딩 어시스턴트 만들기

# Modelfile 생성

FROM gpt-oss-20b

SYSTEM "당신은 Python 전문가입니다. 항상 코드와 함께 상세한 주석을 제공하고, 모범 사례를 따르세요."

PARAMETER temperature 0.3

PARAMETER num_ctx 8192# 커스텀 모델 빌드

ollama create python-expert -f Modelfile

# 실행

ollama run python-expert이제 여러분만의 전문 Python 코딩 어시스턴트가 준비되었습니다.

5단계: API 통합으로 애플리케이션 개발

가장 흥미진진한 단계입니다. Ollama의 API를 활용하면 여러분만의 AI 애플리케이션을 개발할 수 있습니다.

Python으로 간단한 AI 챗봇 만들기

from openai import OpenAI

# Ollama API 클라이언트 설정

client = OpenAI(

base_url="http://localhost:11434/v1",

api_key="ollama"

)

def chat_with_gpt_oss(message):

response = client.chat.completions.create(

model="gpt-oss-20b",

messages=[

{"role": "user", "content": message}

]

)

return response.choices[0].message.content

# 사용 예시

answer = chat_with_gpt_oss("블록체인 기술의 핵심 개념을 설명해줘")

print(answer)6단계: Apidog를 활용한 고급 디버깅

API 개발 과정에서 응답을 시각적으로 분석하고 디버깅하는 것은 매우 중요합니다. Apidog는 이러한 과정을 혁신적으로 간소화해줍니다.

Apidog 설정 과정

- apidog.com에서 도구를 다운로드합니다

- 새 API 요청을 생성하고

http://localhost:11434/api/generate로 설정 - 스트리밍 응답을 실시간으로 모니터링

특히 복잡한 코드 생성이나 단계적 문제 해결 과정에서 AI의 사고 과정을 시각적으로 추적할 수 있어 디버깅 효율성이 크게 향상됩니다.

실무 활용 시나리오: 구체적 사례들

시나리오 1: 스타트업의 MVP 개발

25세 프론트엔드 개발자 김민수 씨는 개인 프로젝트로 할일 관리 앱을 개발하고 있었습니다. 하지만 백엔드 API 설계 경험이 부족해 막막한 상황이었죠. GPT-OSS를 로컬에 설치한 후, 다음과 같은 도움을 받을 수 있었습니다:

- REST API 설계 패턴과 구체적 구현 코드

- 데이터베이스 스키마 최적화 제안

- 보안 취약점 검토 및 개선안

- 무제한 질문과 반복 학습

결과적으로 월 100달러의 API 비용을 절약하면서도 더 깊이 있는 학습 경험을 얻었습니다.

시나리오 2: 중소기업의 데이터 분석 자동화

30명 규모 마케팅 회사의 데이터 분석가 박영희 씨는 매일 반복되는 보고서 생성 작업에 지쳐있었습니다. GPT-OSS를 활용해 다음과 같은 자동화를 구현했습니다:

- 일일 매출 데이터 요약 스크립트 생성

- 고객 행동 패턴 분석 코드 자동 생성

- 시각화 차트 생성을 위한 Python 코드

- 보고서 템플릿 자동 작성

이를 통해 일일 3시간의 반복 작업을 30분으로 단축시켰습니다.

성능 최적화와 문제 해결

메모리 최적화 전략

GPU 메모리 부족 시

- 모델 매개변수 조정으로 메모리 사용량 감소

- 배치 크기 최적화

- 더 작은 모델로 단계적 접근

성능 향상 팁

- SSD 스토리지 사용으로 모델 로딩 속도 개선

- 충분한 시스템 RAM 확보 (최소 32GB 권장)

- GPU 드라이버 최신 버전 유지

일반적인 문제와 해결책

모델 실행 실패

# 서버 상태 확인

ollama serve

# 포트 충돌 확인

netstat -tuln | grep 11434

# 로그 확인

cat ~/.ollama/logs/server.log미래 전망: 로컬 AI의 가능성

GPT-OSS와 Ollama의 조합은 단순한 도구를 넘어 AI 개발 패러다임의 전환점을 의미합니다. 앞으로 더 많은 오픈소스 모델들이 공개되면서, 개발자들은 클라우드 종속성에서 벗어나 진정한 AI 자유도를 경험하게 될 것입니다.

특히 프라이버시가 중요한 금융, 의료, 법률 분야에서 로컬 AI의 활용도는 급격히 증가할 전망입니다. 또한 엣지 컴퓨팅 환경에서의 AI 배포가 일반화되면서, 이러한 로컬 실행 기술은 더욱 중요해질 것입니다.

지금 시작하세요

GPT-OSS와 Ollama를 통한 로컬 AI 환경 구축은 더 이상 선택이 아닌 필수가 되어가고 있습니다. 비용 절감, 프라이버시 보호, 무제한 사용성이라는 세 가지 핵심 가치를 모두 만족시키는 이 혁신적 접근법을 통해, 여러분의 개발 프로젝트와 비즈니스에 새로운 가능성을 열어보시기 바랍니다.

오늘 당장 시작해보세요. 여러분의 컴퓨터가 곧 가장 강력한 AI 워크스테이션이 될 것입니다.

참고 자료: Ashley Innocent, “Ollama 활용하여 GPT-OSS 무료로 실행하는 방법”