메타(Meta)는 오늘날의 기술 산업에서 선도적인 기업 중 하나로, 대규모 언어 모델(LLM)을 훈련하기 위해 끊임없이 노력하고 있습니다. 이러한 훈련 과정은 단순히 많은 데이터를 사용하는 것이 아니라, 엄청난 계산 능력과 고도의 기술적 도전 과제를 요구합니다. 이 글에서는 메타가 어떻게 이러한 도전 과제를 극복하고, 대규모 언어 모델을 성공적으로 훈련할 수 있었는지에 대해 알아보겠습니다. 또한 이 과정에서 직면한 하드웨어 및 소프트웨어 문제와 그 해결 방안, 그리고 향후 전망에 대해 살펴볼 것입니다.

대규모 모델 훈련의 도전 과제

하드웨어 신뢰성

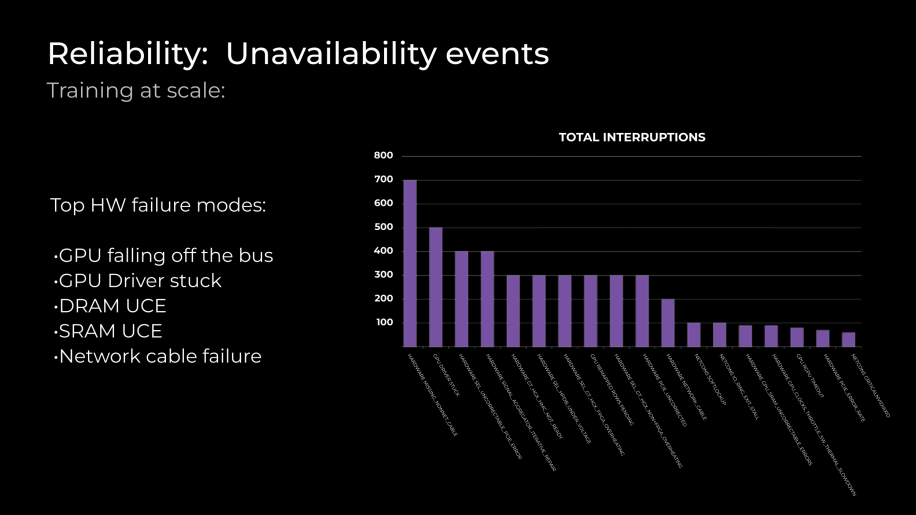

대규모 언어 모델 훈련에서 가장 큰 도전 중 하나는 하드웨어의 신뢰성입니다. 메타는 하드웨어 고장으로 인한 훈련 중단을 최소화하기 위해, 엄격한 테스트와 품질 관리 과정을 거치고 있습니다. 이러한 과정은 특히 훈련이 진행 중일 때 발생하는 하드웨어 고장을 신속하게 감지하고 복구하는 데 초점을 맞추고 있습니다. 예를 들어, 고장 시 빠르게 복구하여 재스케줄링 오버헤드를 줄이고, 훈련을 빠르게 재개할 수 있도록 하는 것이 매우 중요합니다.

GPU 간 최적의 연결성

대규모 언어 모델 훈련에서 또 다른 중요한 요소는 GPU 간의 최적의 연결성입니다. 이를 위해 메타는 고속 네트워크 인프라를 구축하고, 효율적인 데이터 전송 프로토콜을 사용하고 있습니다. 이는 대규모 모델이 훈련될 때, GPU 간의 데이터 전송 속도가 전체 훈련 시간에 큰 영향을 미치기 때문입니다.

인프라 스택의 개선

훈련 소프트웨어

메타는 연구자들이 PyTorch와 같은 오픈 소스 소프트웨어를 사용하여 빠르게 연구를 진행하고, 생산으로 전환할 수 있도록 지원하고 있습니다. 이를 위해 새로운 알고리즘과 기술을 개발하고, 이를 훈련 소프트웨어에 통합하고 있습니다. 이러한 접근 방식은 메타의 대규모 훈련 작업을 더욱 효율적으로 만들어주고 있습니다.

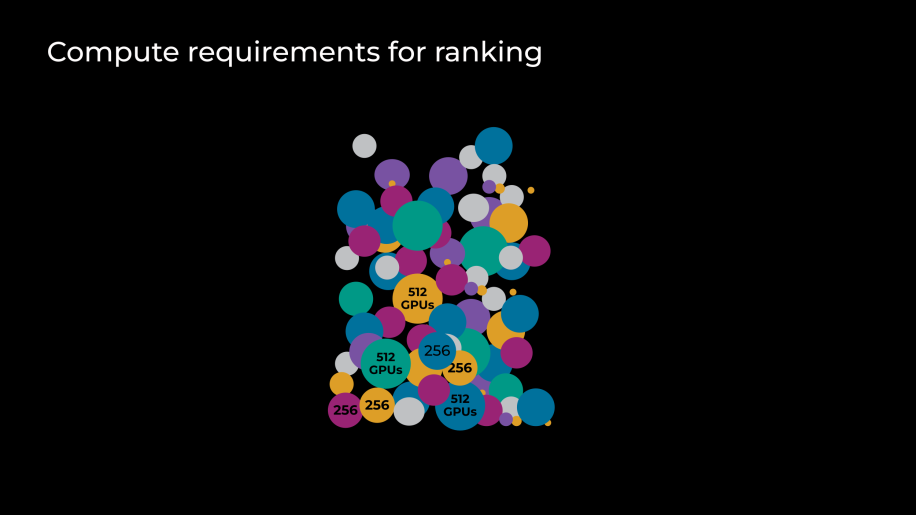

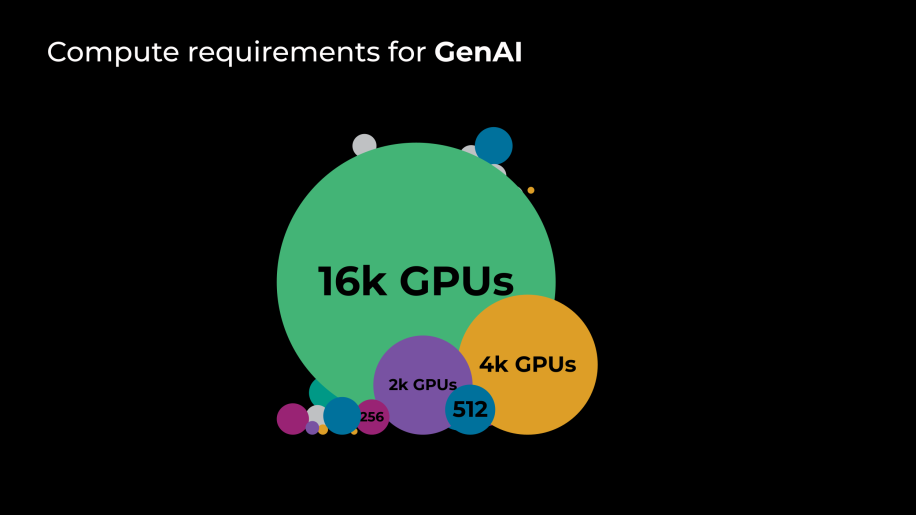

스케줄링

대규모 훈련 작업에서 자원을 최적화하기 위해 복잡한 알고리듬을 사용하여, 작업의 필요에 따라 자원을 동적으로 할당하고 스케줄링하고 있습니다. 이는 자원의 효율적인 사용을 가능하게 하며, 훈련의 속도와 효율성을 높이는 데 기여합니다.

데이터 센터 배치와 신뢰성

데이터 센터 배치

메타는 GPU와 시스템을 데이터 센터에 최적으로 배치하여, 자원(전력, 냉각, 네트워킹 등)을 최적화하고 있습니다. 이를 통해 최대 컴퓨팅 밀도를 달성하고, 훈련 작업의 효율성을 극대화하고 있습니다. 이러한 접근 방식은 메타가 대규모 언어 모델 훈련에서 경쟁 우위를 유지하는 데 중요한 역할을 하고 있습니다.

신뢰성

하드웨어 고장 시 다운타임을 최소화하기 위해, 메타는 감지 및 복구 계획을 수립하고 있습니다. 이는 하드웨어 고장으로 인한 훈련 중단을 최소화하고, 빠르게 복구할 수 있도록 합니다. 예를 들어, 자주 발생하는 고장 모드로는 GPU 인식 불가, DRAM & SRAM UCE, 하드웨어 네트워크 케이블 문제가 있습니다.

향후 전망

메타는 향후 수십만 개의 GPU를 사용하여, 더 많은 데이터를 처리하고, 더 긴 거리와 지연 시간을 다룰 예정입니다. 이를 위해 새로운 하드웨어 기술과 GPU 아키텍처를 채택하고, 인프라를 발전시켜 나갈 것입니다. 이러한 노력을 통해 메타는 AI의 진화하는 환경을 탐색하며, 가능한 한계를 넘어서기 위해 지속적으로 도전할 것이라고 합니다.

결론

메타의 대규모 언어 모델 훈련은 엄청난 기술적 도전과 기회로 가득 차 있습니다. 이 과정에서 메타는 하드웨어 신뢰성, GPU 간 연결성, 훈련 소프트웨어, 데이터 센터 배치 및 신뢰성 등 다양한 요소를 최적화하고 있습니다. 이를 통해 메타는 AI의 진화하는 환경에서 경쟁 우위를 유지하며, 미래의 기술적 발전을 선도할 것입니다.

참고 자료: engineering.fb.com, “How Meta trains large language models at scale”