인공지능(AI) 기술의 발전이 가속화됨에 따라 그 한계와 책임 문제가 점점 더 중요한 논의 주제가 되고 있습니다. 디 몬트포트 대학교의 사이버 보안 교수인 에르케 보이텐(Eerke Boiten)은 현재의 AI 시스템이 심각한 응용 분야에서 사용되기에는 여러 가지 이유로 문제가 있다고 주장합니다. 이번 글에서는 보이텐 교수의 주요 주장과 그 배경을 자세히 분석해보겠습니다.

현재 AI의 한계: 소프트웨어 공학의 관점

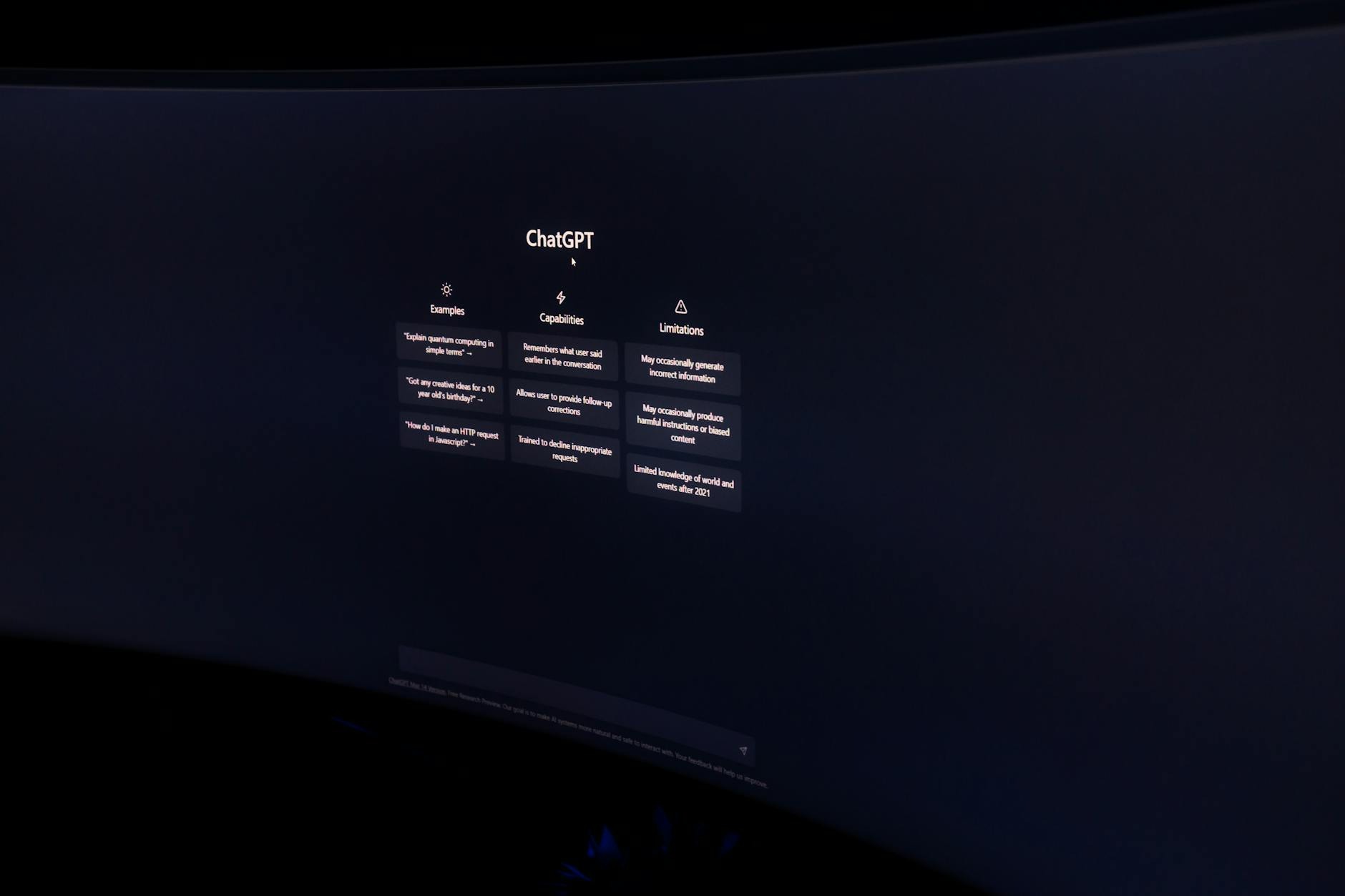

보이텐 교수는 현재의 AI 시스템, 특히 대규모 신경망 기반의 생성형 AI와 대형 언어 모델(LLM)이 관리 불가능하다고 지적합니다. 이러한 시스템들은 복잡성과 규모를 관리하기 위한 도구들이 근본적인 이유로 적용되지 못하고 있으며, 이는 책임 있는 사용을 어렵게 만듭니다. 소프트웨어 공학의 원칙에 따르면, 신뢰할 수 있는 소프트웨어 시스템은 투명하고 책임감 있게 개발되어야 합니다. 그러나 현재 AI 시스템은 이러한 기준을 충족시키지 못하고 있습니다.

AI 윤리와 책임 회피의 문제

2018년 이후 AI 개발은 두 가지 차원에서 책임 회피가 진행되고 있다고 보이텐 교수는 설명합니다. 첫째, ‘빅 데이터’ 시대에 AI가 데이터를 어떻게 수집하고 사용하는지에 대한 관심이 줄어들면서 ‘감시 자본주의’와 같은 문제가 대두되었습니다. 둘째, AI 알고리즘의 결과물이 설계자의 책임이 아니라는 인식이 확산되었습니다. 이러한 상황에서 ‘설명 가능한 AI’와 편향 완화 방안이 일부 개발되었으나, 데이터 책임 문제는 여전히 해결되지 않았습니다.

신경망의 작동 방식과 문제점

보이텐 교수는 현재의 AI 시스템이 수백만 개의 노드로 구성된 고정된 연결 구조를 가진 신경망을 기반으로 한다고 설명합니다. 이러한 시스템은 주로 비지도 학습이나 자기 지도 학습을 통해 훈련되며, 이는 인간의 개입 없이 이루어집니다. 결과적으로 이러한 AI 시스템은 예측 불가능한 ‘출현적’ 행동을 보이며, 이는 소프트웨어 공학에서 요구하는 신뢰성과 투명성을 저해합니다.

컴포지셔널리티와 출현적 행동의 갈등

소프트웨어 공학에서 중요한 개념인 컴포지셔널리티(구성 가능성)는 시스템의 각 부분을 독립적으로 이해하고 개발할 수 있게 합니다. 그러나 현재의 AI 시스템은 내부 구조가 기능과 의미적으로 연결되지 않아 컴포지셔널리티를 실현하기 어렵습니다. 이는 시스템의 검증과 오류 수정에도 큰 장애가 됩니다.

검증과 오류 수정의 어려움

현재 AI 시스템의 검증은 전체 시스템 단위로만 가능하며, 이는 매우 비효율적입니다. 또한, 이러한 시스템은 입력과 상태 공간이 너무 커서 철저한 테스트가 불가능하며, 오류 수정 시에도 새로운 오류가 발생할 가능성이 높습니다. 이는 AI 시스템의 신뢰성을 크게 저하시킵니다.

현재 AI의 한계와 미래 전망

보이텐 교수는 현재의 생성형 AI 시스템이 근본적인 한계로 인해 신뢰성과 책임성을 보장하기 어렵다고 결론짓습니다. 그는 이러한 시스템이 ‘죽은 길’에 있다고 보며, 신경망의 구성 가능성(compositional approaches)이나 상징적 AI와의 하이브리드 모델이 더 나은 대안이 될 수 있다고 제안합니다. 또한, 현재의 AI는 제한된 범위 내에서 보조적인 역할을 수행할 수 있다고 언급합니다.

참고 자료: Professor Eerke Boiten, “Does current AI represent a dead end?”