최근 몇 년 동안 인공지능(AI)과 머신러닝(ML) 기술은 급격한 발전을 이루었습니다. 특히, 거대한 언어 모델(LLM)들은 이제 다양한 애플리케이션에서 중요한 역할을 담당하고 있습니다. 하지만 이런 모델을 로컬 환경에서 실행하는 것은 많은 이들에게 여전히 도전 과제입니다. 그러나 이제 Torchchat을 통해 이 문제를 쉽게 해결할 수 있습니다.

1. Torchchat이란 무엇인가요?

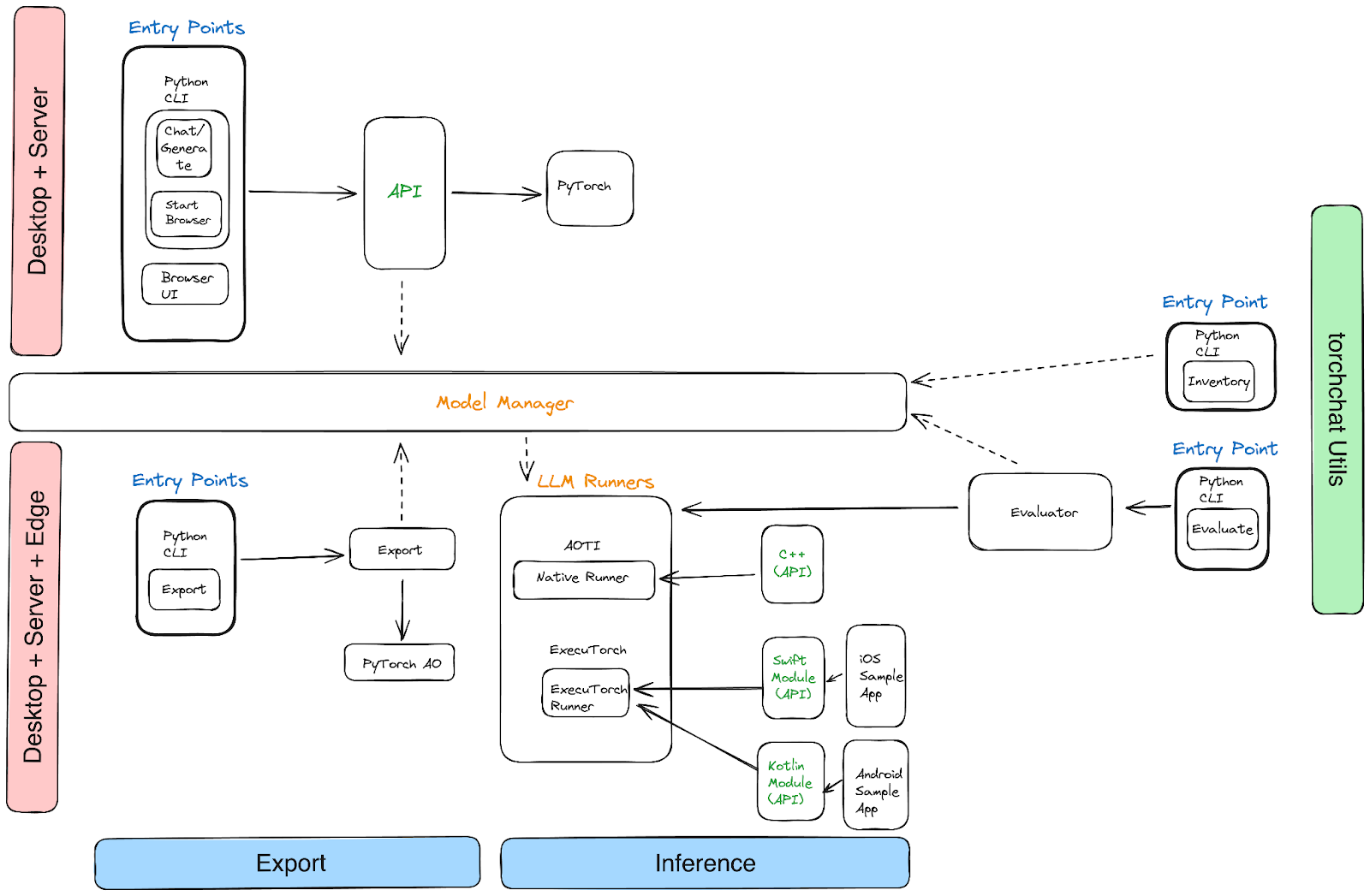

Torchchat은 LLM을 로컬에서 실행할 수 있게 해주는 작은 코드베이스입니다. 이 도구는 Python을 사용해 LLM을 다양한 환경에서 실행할 수 있도록 설계되었습니다. 이는 데스크톱, 서버, iOS, Android 등 다양한 플랫폼을 지원합니다. 즉, Torchchat을 사용하면 어디서나 강력한 언어 모델과 상호작용할 수 있습니다.

2. Torchchat의 주요 기능

Torchchat은 여러 가지 유용한 기능을 제공합니다. 다음은 그 중 몇 가지 주요 기능입니다.

- 다양한 모델 지원: Llama 3, Mistral 등의 인기 있는 LLM과의 커맨드 라인 인터랙션을 제공합니다.

- 다양한 데이터 유형 지원: float32, float16, bfloat16 등 다양한 데이터 유형을 다룰 수 있습니다.

- 다양한 양자화 스킴 지원: Torchchat은 다양한 양자화 스킴을 지원하여 성능을 최적화할 수 있습니다.

- 멀티 실행 모드: Python 환경에서의 실행은 물론, 네이티브 실행 모드(AOT Inductor, ExecuTorch)도 지원합니다.

3. 데스크톱과 모바일에서의 LLM 실행

Torchchat은 다양한 플랫폼에서 활용될 수 있습니다. 예를 들어, 데스크톱 환경에서는 Llama 3 모델을 사용하여 텍스트 생성 작업을 수행할 수 있으며, 모바일 환경에서는 Android 또는 iOS에서 LLM을 실행해 실시간으로 언어 모델과 대화할 수 있습니다. 이처럼 다양한 환경에서 LLM을 활용할 수 있다는 점이 Torchchat의 가장 큰 장점입니다.

4. 설치 및 사용법

Torchchat을 사용하려면 몇 가지 간단한 설치 단계가 필요합니다. 먼저, Python 3.10을 설치한 후, 다음 명령어를 실행하면 됩니다.

# 코드 다운로드

git clone https://github.com/pytorch/torchchat.git

cd torchchat

# 가상 환경 설정

python3 -m venv .venv

source .venv/bin/activate

# 종속성 설치

./install_requirements.sh이후 다양한 명령어를 통해 모델과 상호작용할 수 있습니다. 예를 들어, CLI에서 Llama 3.1 모델과 대화하려면 다음 명령어를 사용할 수 있습니다.

python3 torchchat.py chat llama3.15. Torchchat의 잠재력

Torchchat은 단순히 LLM을 실행하는 도구 이상의 역할을 할 수 있습니다. 이 도구를 통해 개발자와 연구원들은 다양한 환경에서 언어 모델을 테스트하고, 성능을 최적화하며, 실제 애플리케이션에 통합할 수 있습니다. 이제 Torchchat 덕분에 더 이상 복잡한 서버 설정 없이도 로컬에서 강력한 언어 모델을 쉽게 사용할 수 있게 된 것이죠.

결론

LLM을 로컬에서 실행하고자 하는 모든 이들에게 Torchchat은 강력한 해결책이 될 것입니다. 이 도구를 통해 다양한 플랫폼에서 LLM을 쉽게 실행하고, 자신의 애플리케이션에 통합할 수 있습니다. 지금 바로 Torchchat을 설치하고, 그 가능성을 경험해보세요!

참고 자료: github, “torchchat”