로컬 환경에서 대규모 언어 모델(LLM)을 실행하고 싶으신가요? 그렇다면 Ollama가 바로 여러분을 위한 솔루션입니다. Ollama는 LLaMA, Mistral 등의 유명한 LLM 모델을 쉽게 사용할 수 있도록 로컬에서 서버 형식으로 구성할 수 있습니다. 이번 글에서는 Ollama를 설치하고 사용하는 방법을 상세히 안내해 드리겠습니다.

Ollama란 무엇인가?

Ollama는 대규모 언어 모델을 로컬 환경에서 실행할 수 있는 프레임워크입니다. LLaMA, Mistral 등 다양한 모델을 지원하며, 사용법이 간단해 누구나 쉽게 LLM을 실행하고 배포할 수 있습니다. Ollama를 통해 로컬 서버 형태로 LLM을 구동할 수 있어, 개발자들에게 큰 도움이 됩니다.

Ollama 설치 방법

Ollama를 설치하는 방법은 매우 간단합니다. 아래의 단계를 따라 설치를 진행해보세요.

1. MacOS의 경우

curl -fsSL https://ollama.com/install.sh | sh2. Linux의 경우

curl -fsSL https://ollama.com/install.sh | sh3. Windows의 경우

Windows 설치 파일을 다운로드하여 실행하면 됩니다. 현재는 프리뷰 상태이므로 안정성에 주의하세요.

Ollama 실행 방법

Ollama가 설치되었다면, 이제 실행해보겠습니다. 여기서는 MacOS 환경을 기준으로 설명하겠습니다.

1. Ollama 명령어 실행

ollama list이 명령어를 입력하면 설치된 모델 리스트가 출력됩니다.

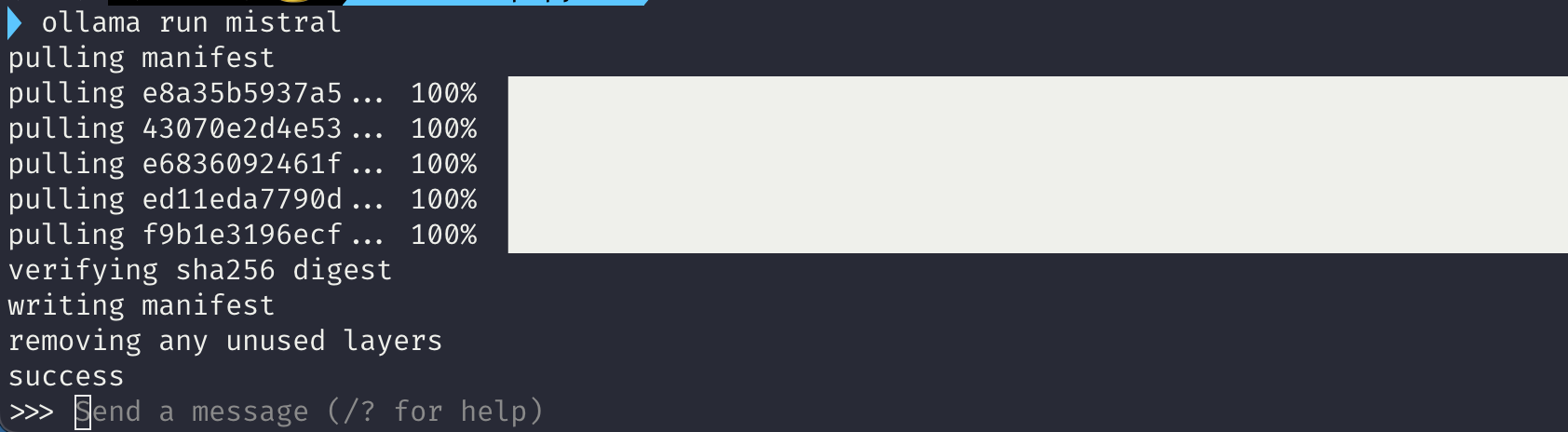

2. 모델 다운로드 및 실행

ollama run mistral이 명령어를 입력하면 mistral 모델이 다운로드되고 실행됩니다.

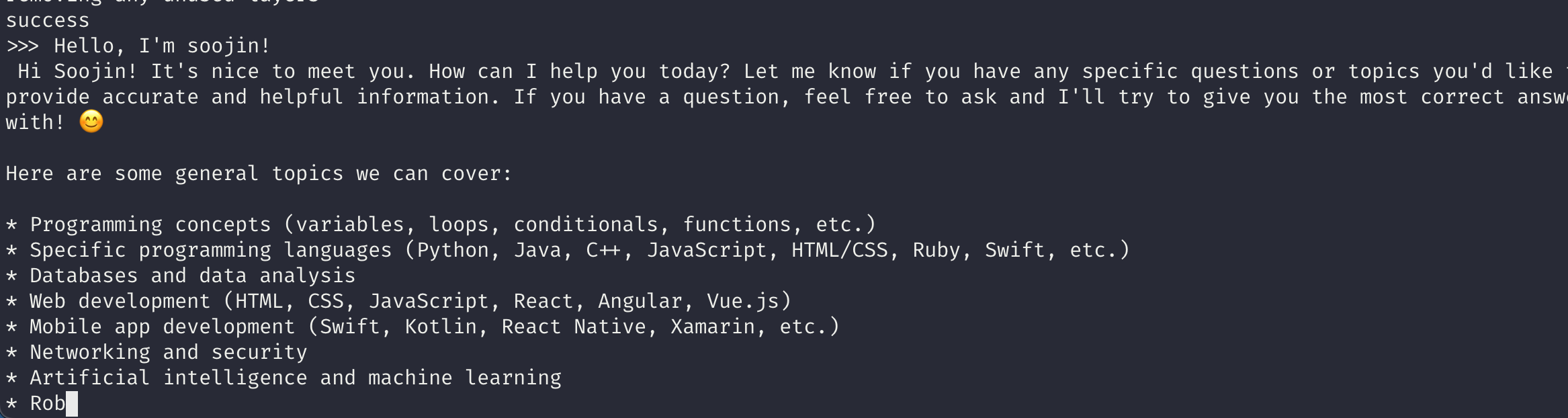

3. 메시지 입력

>>> Hello, I'm jack!이렇게 입력하면 모델이 인사를 하고 메시지를 생성하기 시작합니다.

4. 프롬프트 종료

/bye이 명령어를 입력하면 프롬프트를 종료할 수 있습니다.

Ollama API 실행 방법

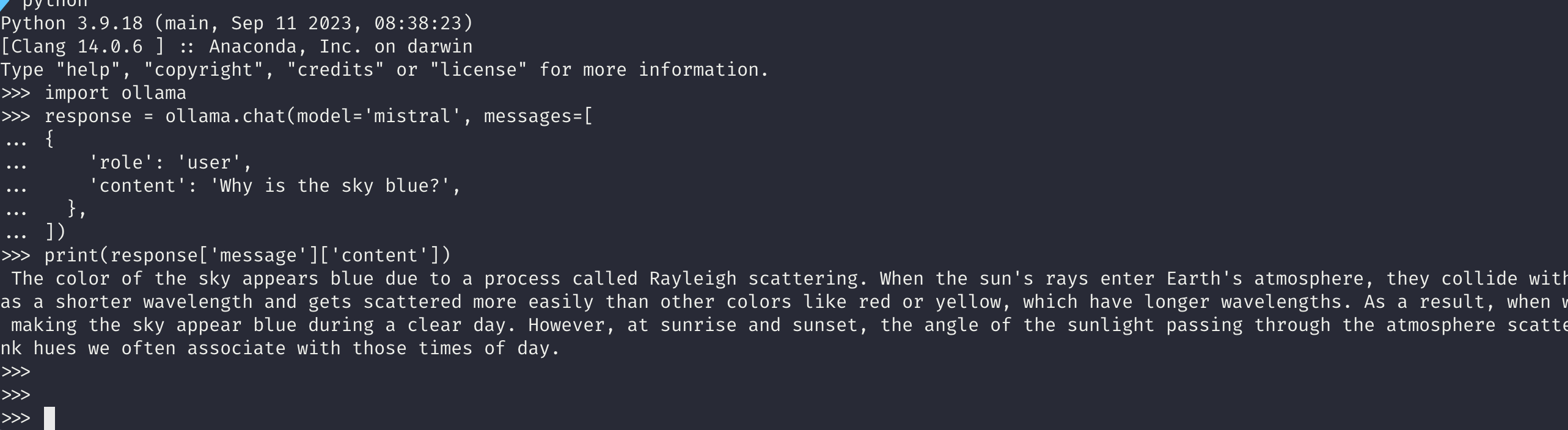

Ollama는 API 형식으로도 실행할 수 있습니다. 이를 위해 Python에서 Ollama를 실행하는 방법을 알아보겠습니다.

1. Python 패키지 설치

pip install ollama2. API 통신 코드

import ollama

response = ollama.chat(model='mistral', messages=[

{

'role': 'user',

'content': 'Why is the sky blue?',

},

])

print(response['message']['content'])

3. 스트리밍 출력 코드

stream = ollama.chat(

model='mistral',

messages=[{'role': 'user', 'content': 'Why is the sky blue?'}],

stream=True,

)

for chunk in stream:

print(chunk['message']['content'], end='', flush=True)Modelfile을 활용한 모델 배포

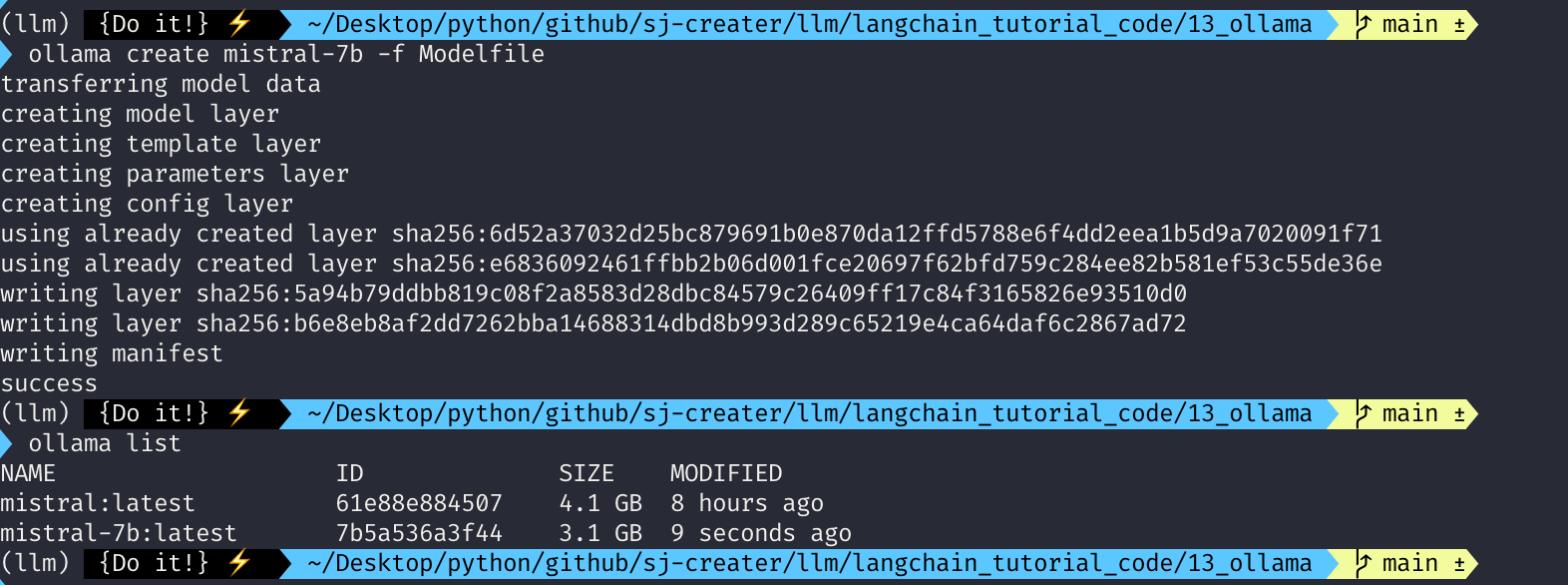

Modelfile을 사용하면 Dockerfile과 유사하게 모델을 구성할 수 있습니다. 예를 들어, Mistral 모델을 배포하기 위한 Modelfile은 다음과 같이 작성할 수 있습니다.

FROM mistral-7b-instruct-v0.2.Q2_K.gguf

TEMPLATE """[INST] {{ .System }} {{ .Prompt }} [/INST]"""

PARAMETER stop "[INST]"

PARAMETER stop "[/INST]"이제 이 Modelfile을 활용해 Ollama에 모델을 배포해보겠습니다.

ollama create mistral-7b -f Modelfile이 명령어를 실행하면 새로운 모델이 생성되고, ollama list 명령어로 확인할 수 있습니다.

마무리

이번 글에서는 Ollama를 사용해 대규모 언어 모델을 로컬 환경에서 실행하고 배포하는 방법을 알아보았습니다. Ollama 설치부터 모델 실행, API 호출, 그리고 Modelfile을 활용한 모델 배포까지 모든 과정을 상세히 설명드렸습니다. Ollama를 통해 여러분의 개발 환경이 더욱 편리해지길 바랍니다.

참고 자료: Ollama 공식 사이트, “https://ollama.com”