최근 인공지능 분야에서 대규모 언어 모델(LLM)의 활용이 급증하면서, 이를 로컬 환경에서 실행하는 방법에 대한 관심이 높아지고 있습니다. 본 글에서는 로컬에서 LLM을 성공적으로 실행하기 위한 필수 요소와 도구, 모델 선택 방법 등을 상세히 소개합니다.

1. 로컬 LLM 실행의 필요성

로컬에서 LLM을 실행함으로써 데이터에 대한 완전한 제어와 낮은 응답 지연을 실현할 수 있습니다. 클라우드 기반 서비스와 달리, 로컬 실행은 개인정보 보호와 데이터 보안 측면에서 큰 장점을 제공합니다. 또한, 오픈소스 프로젝트와 무료 모델의 발전 덕분에 개인 및 소규모 팀도 손쉽게 LLM을 활용할 수 있게 되었습니다.

2. 하드웨어 구성

효율적인 LLM 실행을 위해 적절한 하드웨어 구성이 필수적입니다. 다음은 권장 사양입니다:

- CPU: Intel Core i9 (32 스레드)

- GPU: NVIDIA RTX 4090 (16GB VRAM)

- RAM: 96GB

- 운영체제: Linux 기반 랩톱

VRAM 용량에 맞는 모델을 선택하면 빠른 속도로 작동할 수 있으며, 큰 모델은 RAM으로 오프로드되어 속도가 다소 느려질 수 있습니다. 하지만 고성능 컴퓨터가 필수적인 것은 아니며, 작은 모델은 구형 GPU나 CPU에서도 실행 가능합니다.

3. 필수 사용 도구

로컬에서 LLM을 효율적으로 실행하기 위해 다음과 같은 오픈소스 도구들을 활용할 수 있습니다:

- Ollama: Llama.cpp를 실행하기 위한 Python 및 JavaScript 라이브러리를 포함한 미들웨어로, Docker 환경에서 사용됩니다.

- Open WebUI: 텍스트 및 이미지 입력을 위한 사용자 친화적인 인터페이스를 제공하며, Ollama 백엔드와 통신하여 출력을 스트리밍합니다.

- llamafile: 단일 실행 파일로 LLM을 실행할 수 있는 도구로, 로컬 LLM 시작에 가장 쉬운 방법 중 하나입니다.

- AUTOMATIC1111 및 Fooocus: 이미지 생성 도구로, 복잡한 워크플로우에는 ComfyUI를 사용합니다.

- Continue: VSCode에서 코드 자동 완성을 지원하는 도구입니다.

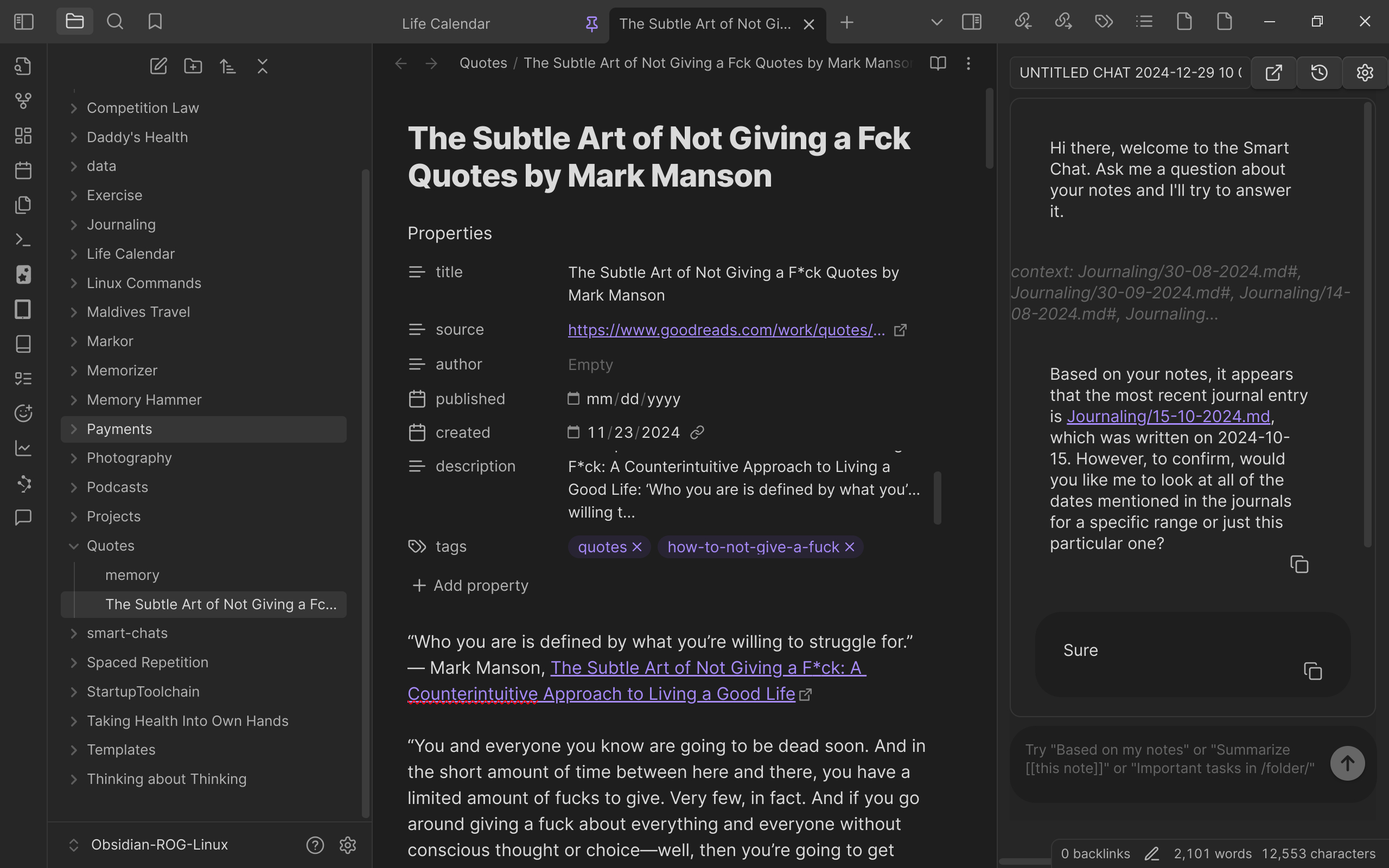

- Obsidian Smart Connections: Ollama를 사용해 메모를 쿼리할 수 있는 기능을 제공합니다.

4. 모델 선택 및 관리

최신 LLM을 다운로드하고 관리하는 것은 중요한 단계입니다. 다음은 모델 선택과 관리에 관한 주요 사항입니다:

- 모델 다운로드: Ollama의 모델 페이지를 통해 최신 LLM을 다운로드할 수 있으며, RSS 피드를 통해 모델 업데이트를 추적할 수 있습니다.

- 이미지 생성 모델: CivitAI에서 다양한 스타일의 이미지 생성 모델을 다운로드할 수 있습니다. 단, 일부 모델은 성인 이미지 생성에 최적화되어 있으므로 주의가 필요합니다.

- 주요 사용 모델:

- ㆍ Llama3.2: 일반 쿼리와 Smart Connections에 사용

- ㆍ Deepseek-coder-v2: VSCode의 코드 완성에 사용

- ㆍ Qwen2.5-coder: 코드 관련 대화에 사용

- ㆍ Stable Diffusion: 이미지 생성에 사용

5. 업데이트 및 유지 관리

로컬 환경에서 LLM을 최신 상태로 유지하는 것은 성능과 보안 측면에서 중요합니다. 다음과 같은 방법으로 업데이트를 관리할 수 있습니다:

- WatchTower: Docker 컨테이너 업데이트를 자동화하는 도구입니다.

- Open WebUI: 모델 업데이트를 통해 최신 기능과 성능 향상을 누릴 수 있습니다.

현재는 파인튜닝이나 양자화를 진행하지 않고 있으며, 이는 CPU의 결함 가능성으로 인해 장시간 고온 작업을 피하기 위함입니다.

결론

로컬에서 LLM을 실행하는 것은 데이터에 대한 완전한 제어와 낮은 응답 지연을 제공하며, 이는 클라우드 기반 서비스와 비교할 때 큰 이점을 제공합니다. 오픈소스 프로젝트와 무료 모델의 지원 덕분에 개인 사용자부터 전문가에 이르기까지 다양한 사용자가 로컬 LLM을 활용할 수 있게 되었습니다. 앞으로도 새로운 도구와 모델이 등장함에 따라 로컬 LLM 실행 환경은 더욱 발전할 것으로 기대됩니다.

관련 자료

- r/LocalLLaMA 서브레딧

- Ollama 블로그

- Ollama 다운로드 페이지

- llama.cpp GitHub

- Ollama Docker 이미지

- Open WebUI GitHub

- llamafile GitHub

- llamafile 이슈 #611

- AUTOMATIC1111 Stable Diffusion WebUI

- Fooocus GitHub

- ComfyUI GitHub

- Continue 문서

- Obsidian Smart Connections GitHub

- Obsidian 공식 사이트

- Ollama 모델 검색

- CivitAI 이미지 생성 모델

- WatchTower 공식 사이트

- Wikipedia: Raptor Lake Instability and Degradation Issue

참고 자료: Abishek Muthian, “How I run LLMs locally”